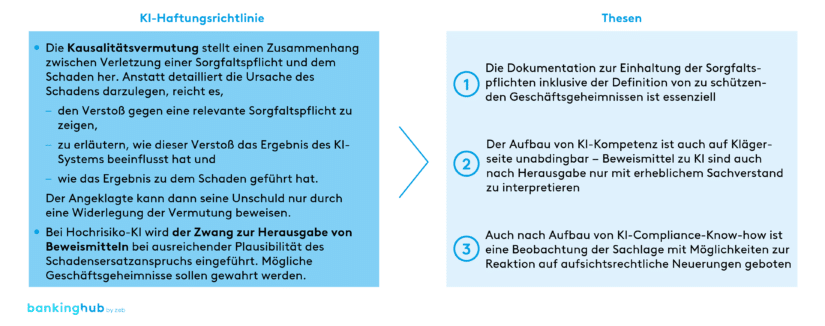

Veranschaulichung der KI-Haftungsrichtlinie

In Finnland verklagte 2018 ein Antragsteller seine Bank aufgrund eines verwehrten Kredits wegen Diskriminierung vor dem Nichtdiskriminierungs- und Gleichheitstribunal von Finnland. Das Tribunal entschied zugunsten des Klägers, u. a. da geschützte Merkmale wie Geschlecht, Muttersprache, Alter und Wohnort verwendet worden waren und zu einer Verweigerung der Kreditvergabe geführt hatten[1].

Situationen wie diese könnten in Zukunft häufiger die Gerichte beschäftigen: Falls die Ergebnisse von KI-Systemen[2] im Verdacht stehen, einen Schaden zu verursachen, sollen nach dem Willen der Europäischen Kommission bald neue Haftungsregeln gelten, nach denen die Beweislast beim Finanzinstitut liegen könnte. Inwieweit beeinflusst die neue KI-Haftungsrichtlinie die bereits hochregulierte Finanzbranche – auch in Deutschland?

Kausalitätsvermutung und Zwang zur Herausgabe von Beweismitteln sollen Schutzniveau erhöhen

Bei Schadensersatzklagen muss grundsätzlich die Ursache des Schadens dargelegt werden, was aber aufgrund der „Blackbox“ bei KI-Anwendungen sehr schwierig ist. In der Richtlinienbegründung führt die Europäische Kommission weiter aus, dass unklare KI-Haftungsregelungen eine wesentliche Hürde für den Einsatz von KI in Finanzinstituten sind. Um ein gleichwertiges Schutzniveau bei Schäden mit KI und ohne KI zu gewährleisten sowie Innovationen zu fördern, soll die KI-Haftungsrichtlinie verabschiedet werden.

Hauptbestandteil dieser sind insbesondere zwei Instrumente:

- Zum einen die Kausalitätsvermutung, welche einen direkten Zusammenhang zwischen der Verletzung einer Sorgfaltspflicht und dem entstandenen Schaden herstellt. Hierzu muss der Kläger bzw. die Klägerin die Erfüllung mehrerer Voraussetzungen nachweisen: Zunächst ist ein Verstoß gegen eine relevante Sorgfaltspflicht aufzuzeigen. Dann muss das fehlerhafte Verhalten der KI das Ergebnis „nach vernünftigem Ermessen“[3] beeinflusst und schließlich auch zu dem Schaden geführt haben. Wird die Kausalitätsvermutung auf Grundlage dieser Nachweise hergestellt, kann der Angeklagte seine Unschuld durch eine Widerlegung dieser Vermutung beweisen.

- Bei Hochrisiko-KI[4] wird dem Kläger/der Klägerin mit dem Zwang zur Herausgabe von Beweismitteln ein weiteres Instrument zur Verfügung gestellt. Kläger/-innen dürfen die Offenlegung von Beweismitteln für KI-Systeme fordern, sofern die Plausibilität des Schadensersatzanspruchs „ausreichend belegt“[5] ist. Die Rechte des Beklagten bezüglich der Wahrung von Geschäftsgeheimnissen und vertraulichen Informationen sollen explizit berücksichtigt werden – die Offenlegung soll „erforderlich und verhältnismäßig“[6] sein. Kommt ein Beklagter dieser Verpflichtung zur Offenlegung nicht nach, wird vermutet, dass dieser gegen eine relevante Sorgfaltspflicht verstoßen hat, womit die erste Voraussetzung für das Inkrafttreten der Kausalitätsvermutung bereits gezeigt wäre. Auch hier hat der Beklagte das Recht, die Vermutung zu widerlegen. Durch diese rechtlichen Regelungen lassen sich drei zentrale Thesen ableiten, die für Finanzinstitute an Bedeutung gewinnen (siehe Abb. 1):

These 1: Die Dokumentation zur Einhaltung der Sorgfaltspflichten inklusive der Definition von zu schützenden Geschäftsgeheimnissen ist essenziell

Die zentrale Grundvoraussetzung für die Widerlegung der Kausalitätsvermutung ist die Einhaltung der im Schadenskontext relevanten Sorgfaltspflicht. Um den Nachweis der Einhaltung zu erbringen, muss der Angeklagte auf Dokumentationen zurückgreifen können, welche die Erfüllung der Sorgfaltspflicht belegen.

Allerdings lässt die aktuelle KI-Haftungsrichtlinie in weiten Teilen offen, um welche konkreten Sorgfaltspflichten und damit verbundenen Dokumentationen es sich handelt. Lediglich für Hochrisiko-KI sind die einzuhaltenden Sorgfaltspflichten mit einem Verweis auf das Gesetz über künstliche Intelligenz spezifisch definiert (z. B. Qualitätskriterien für die Nutzung von Trainingsdatensätzen der KI). Für weitere KI-Systeme wird jedoch nur auf nationales und EU-Recht verwiesen. Aber auch in diesem Fall bietet sich eine Orientierung am Gesetz über künstliche Intelligenz an, da es eng mit der Haftungsrichtlinie verknüpft ist.

Im Fall von Hochrisiko-KI-Systemen ist zusätzlich zu beachten, dass auf Forderung des Klägers/der Klägerin sämtliche relevanten Beweismittel offenzulegen sind – die Begrenzung des Umfangs dieser Offenlegung auf ein „erforderlich[es] und verhältnismäßig[es]“[7] Maß dürfte durch eine durchgängige und präzise Dokumentation der Funktionsweise des KI-Systems und seiner Komponenten vereinfacht werden. Dies gilt insbesondere dann, wenn vertrauliche Informationen oder Geschäftsgeheimnisse zu den möglichen Beweismitteln zählen. Geschäftsgeheimnisse sollten daher klar als solche gekennzeichnet werden, sodass bei einer Offenlegung auch Jahre nach dem Erstellen der Dokumentation keine Institutsinteressen verletzt werden.

These 2: Der Aufbau von KI-Kompetenz ist auch auf Klägerseite unabdingbar – Beweismittel zu KI sind auch nach Herausgabe nur mit erheblichem Sachverstand zu interpretieren

Finanzinstitute kommen selbstverständlich nicht nur als Bereitsteller von KI-Systemen infrage, sondern auch als Nutzer. Und auch wenn die KI-Haftungsrichtlinie es erleichtern soll, in einem durch KI herbeigeführten Schadensfall eine Haftungsklage zu erheben, bleiben dennoch umfangreiche Kenntnisse aufseiten des Klägers/der Klägerin unerlässlich. So liegt es weiterhin an diesem bzw. dieser, die Verletzung relevanter Sorgfaltspflichten nachzuweisen und einzuschätzen, ob die Gesamtumstände des Schadensfalls eine Anwendung der Kausalitätsvermutung zulassen.

Im speziellen Fall der Hochrisiko-KI kann die Kausalitätsvermutung darüber hinaus ausgesetzt werden, sofern der Kläger oder die Klägerin „zu vertretbaren Bedingungen auf ausreichende Beweismittel und Fachkenntnisse zugreifen kann“[8] – dann liegt es am Kläger/der Klägerin, die Kausalität selbst nachzuweisen.

These 3: Auch nach Aufbau von KI-Compliance-Know-how ist eine Beobachtung der Sachlage mit Möglichkeiten zur Reaktion auf aufsichtsrechtliche Neuerungen geboten

Der aktuelle Richtlinienentwurf gibt eine klare Zielrichtung vor, trotzdem können sich bis zu seiner Annahme durch das Europäische Parlament und den Rat der Europäischen Union Änderungen ergeben. Des Weiteren ist die Auslegung einzelner Formulierungen in der KI-Haftungsrichtlinie nach aktuellem Stand noch nicht klar: Wann ist die Plausibilität des Schadensersatzanspruchs „ausreichend belegt“[9]? Welche Beweismittel bzw. Geschäftsgeheimnisse sind „verhältnismäßig“[10]? Wie ist „vernünftiges Ermessen“[11] zu interpretieren? Eine aufmerksame Beobachtung relevanter Rechtsprechung und aufsichtlicher Neuerungen ist deshalb erforderlich.

BankingHub-Newsletter

„(erforderlich)“ zeigt erforderliche Felder an

Schaffung von Rechtssicherheit durch die KI-Haftungsrichtlinie ist zu begrüßen

Wie in der Richtlinie erläutert stellt die unklare Rechtslage bei Haftungsfragen aktuell eine wesentliche Hürde für den Einsatz von KI in Finanzinstituten dar. Nach unserer zeb-Meinung bietet der Richtlinienentwurf einen Ansatz, der mehr Rechtssicherheit schafft, gleichzeitig allerdings die Haftungssituation von Finanzinstituten verschärft – insbesondere die Kausalitätsvermutung kann in der Praxis einer abgemilderten Beweislastumkehr entsprechen.

Gleichwohl gibt es zurzeit – vor allem aufgrund der beträchtlichen schon vorhandenen Regulierungen – bei Finanzdienstleistern wenige Anwendungsfälle, in denen die KI-Haftungsrichtlinie in ihrer aktuellen Form wesentliche Auswirkungen hätte. So sind beispielsweise bei Kreditwürdigkeitsprüfungen bereits umfangreiche Mechanismen vorhanden, welche vergleichbare Schutzfunktionen für Antragsteller/-innen beinhalten. Wichtig ist deshalb, bereits zu Beginn der Entwicklung von neuen KI-Lösungen die Anforderungen der KI-Haftungsrichtlinie zu berücksichtigen.