Data Science ist eine Aufgabe von strategischer Relevanz

Eine informelle Umfrage auf den Avaloq Community Conferences hat ergeben, dass Wealth Manager erst ungefähr 35 Prozent der Daten, die ihnen zur Verfügung stehen, tatsächlich nutzen und auswerten. Der Handlungsbedarf in Sachen KI und fortgeschrittener Analysemethoden ist den meisten in der Branche offenbar bewusst, nur mangelt es an der Umsetzung. Allerdings hilft es wenig, sich blauäugig in sein Data Science-Projekt zu stürzen – und zu hoffen, früher oder später werde es schon die erhofften Ergebnisse liefern. Data Science ist eine Aufgabe von strategischer Relevanz, die Finanzinstitute entsprechend planvoll angehen sollten.

Data Science-Projekte entscheiden über Zukunftsfähigkeit

Banking und Wealth Management ist zwar ein Geschäft, bei dem große Datenmengen anfallen, aber zugleich arbeiten viele Finanzinstitute auf sehr traditionelle Weise. In solchen Organisationen einen modernen, datengetriebenen Ansatz zu vermitteln, ist nicht ganz einfach. Data Science ist eben nicht nur ein Experiment oder das jüngste Marketing-Schlagwort. Um im Wettbewerbsumfeld der Zukunft zu bestehen, ist sie überlebenswichtig. Ein Data Science-Projekt braucht darum die Unterstützung von ganz oben: ein klares strategisches Commitment auf Vorstandsebene.

Priorität für die gesamte Organisation

Das Engagement des Vorstands ist das eine, das der gesamten Organisation aber das andere. Der Erfolg eines Datenanalyse-Projekts hängt darum ebenso von einem wirkungsvollen Change Management ab. Es braucht das Verständnis und die Zustimmung in der gesamten Organisation, vom Relationship Manager im Front Office bis zum Legal Officer im Back Office. Der Wandel zu einer datengetriebenen Organisation ist eine Frage der Unternehmensstrategie und der Unternehmenskultur. Er muss in den Köpfen ankommen.

Agiles Vorgehen in abteilungsübergreifende Team

Ein agiler organisatorischer Rahmen kann darum ein wesentlicher Bestandteil des Projekterfolgs sein. Wenn engagierte Mitarbeiter mit unterschiedlichen Fähigkeiten in gemischt besetzten Teams zusammenarbeiten, um in einer Kette von Sprints und auf iterative Weise neue Produkte zu entwickeln, führt dies nicht nur schneller und effektiver zum Ziel. Ein agiler Ansatz kann auch die Mitarbeiter ganz anders involvieren und dank der gemischten Teams besser in die Organisation hineinwirken. Partizipation ist eine wichtige Voraussetzung für effektiven Wandel.

BankingHub-Newsletter

„(erforderlich)“ zeigt erforderliche Felder an

Die strategische KI-Roadmap

Mit großen Datenmengen umzugehen und aus ihnen durch geeignete Analysen wertvolle Erkenntnisse abzuleiten, ist keine triviale Aufgabe. Ein Data Science-Projekt braucht einiges an Ressourcen und Investitionen. Ohne eine passende Strategie und einen sinnvollen Fahrplan werden die großen Datenmengen, die zu verarbeiten sind, für die Organisation eher zur Belastung als zur Chance. Besonders effektiv ist es, nutzerzentriert von Anwendungsfällen auszugehen und diese in verschiedenen Geschäftsbereichen zu bündeln. Dies lässt sich mit einem vielfältigen Portfolio an KI-Projekten kombinieren, von Wachstumsinitiativen für das Front Office bis hin zu Projekten für die Risikominimierung oder die Effizienzsteigerung im Back Office.

Technologische Komplexität in den Griff bekommen

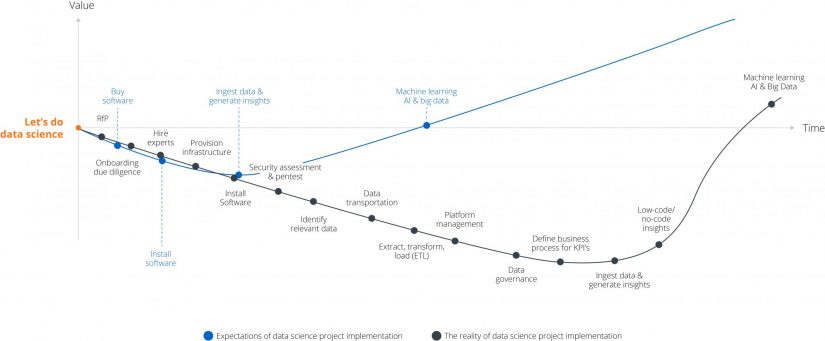

Die Tools und die Hardware für ein Data Science-Projekt erfordern nicht nur ein initiales Investment, sondern benötigen auch noch erhebliche Ressourcen, nachdem sie eingerichtet sind. Schon allein dem beachtlichen Speicherbedarf für all die Daten zu genügen und eine Daten-Infrastruktur zu schaffen, die den Bedarf in Zukunft noch erfüllt, ist eine erhebliche Aufgabe. Dies gilt nicht zuletzt vor dem Hintergrund, dass der Platz in den Data-Centern vieler Finanzinstitute recht beschränkt ist. Es ist eben nicht damit getan, einen hochqualifizierten Datenwissenschaftler mit Doktortitel einzustellen und die moderne große Datensoftware zu implementieren. Data Science-Projekte haben einen anhaltend hohen Bedarf an Infrastruktur-Ressourcen. Zudem entfalten sie disruptives Potenzial und stellen besondere Anforderungen an Sicherheit, Datenschutz und Verfügbarkeit.

Saubere Daten als unverzichtbare Grundlage

Für den reibungslosen Workflow in Data Science-Prozessen stellt es oft die größte Herausforderung dar, unvollständige und unsaubere Datensätze aufzubereiten. Schon die Informationen aus einem Klientenprofil weisen oft erhebliche Lücken auf. Dass hier Daten fehlen, ist keine Seltenheit, besonders dann, wenn Informationen im Free-Text-Format erfasst sind. Größere Organisationen, auch im Bereich der Finanzdienstleistung, haben darum in den vergangenen Jahren oft schon erheblich investiert, um Datensilos aufzulösen, Systeme zu konsolidieren und Daten aus verschiedensten Quellen sinnvoll zusammenzuführen. Innovative Technologie kann hier entscheidend helfen und die Datenqualität sichern. So dienen Methoden des Machine Learnings dazu, Entitäten auf effiziente Weise aufzulösen und Datensätze miteinander zu verknüpfen.

Machine Learning im Branchenmaßstab

Um gute Ergebnisse zu bringen, benötigen Machine Learning-Technologien wie Deep Learning bzw. tiefe neuronale Netze oft sehr viele verschiedene Trainingsdaten. Ein Open-Banking-Ansatz und ein großes Ökosystem können wesentlich dabei helfen, die Prognosefähigkeiten von Machine Learning zu steigern. Denn ein relativ neues Konzept namens Federated (bzw. Collaborative) Learning, das auch Technologiegiganten wie Google und Apple nutzen, ermöglicht es, Algorithmen auf einer großen Basis von Trainingsdaten zu verbessern – ohne dabei den Erfordernissen des Datenschutzes zu widersprechen.