Kosten der Risikobeherrschung

Zahlreiche während und nach der Finanzmarktkrise schlagend gewordene Risiken werden mit einer fehlenden Risikokultur in Verbindung gebracht: So stellte die einflussreiche „Group of Thirty“ (G30) vor Kurzem zusammenfassend fest, dass instituts- und länderübergreifend Risikokultur und Verhaltensweisen im Finanzsystem nicht ausreichen, um bestehende und zukünftige Risiken zu beherrschen.[1]

In der Stellungnahme der G30 heißt es unter anderem: „Die meisten Banken haben große Anstrengungen in der Kulturveränderung im Hinblick auf erwartete Einstellungen unternommen … scheitern aber immer noch an der Umsetzung.“

Internationale und nationale Regulatoren verlangen die Stärkung der bestehenden Risikokultur über die gesetzlichen Anforderungen hinaus, um zu einer besseren Marktreputation und Stabilität der Finanzinstitute zu kommen. Ein Beispiel dafür ist die Denkschrift der Bundesanstalt für Finanzdienstleistungsaufsicht (BaFin) mit dem Titel „Anforderung an eine verantwortungsvolle Unternehmensführung“, in der substanzielle Verbesserungen in vier Bereichen gefordert werden: Dazu gehören 1) eine risikobewusste Leitungskultur (Tone from the Top), 2) die Verantwortlichkeit der Mitarbeiter (Accountability), 3) eine offene Kommunikation und ein kritischer Dialog (Communication & Challenge) sowie 4) angemessene Anreizstrukturen (Incentives). In den Handlungsempfehlungen der G30 liest sich das wie folgt: „Es ist die erste Verantwortung der Geschäftsführung (CEO und Executive Team) sicherzustellen, dass dem ‚tone from the top‘ ein klares und konsistentes ‚echo from the bottom‘ folgt!“

Die Banken haben auf diese Anforderungen reagiert und ihre Anstrengungen im Bereich Regulatorik enorm ausgeweitet: Die jährlichen Gesamtkosten für regulatorische Anforderungen allein bei den 13 systemrelevanten Instituten in Europa werden von der Association for Financial Markets in Europe (AFME) auf ca. 33 Mrd. EUR geschätzt. Zentrale Maßnahmen waren neben der Erhöhung des „harten Kernkapitals“ vor allem die Verschärfung interner Kontrollen und die Einstellung von mehr Kontrollpersonal. Dieser Studie zufolge ist der Return on Equity (ROE) vor Steuern durch Regulierung in den Jahren 2010 bis 2016 von durchschnittlich 17 % auf 3 % gesunken und hat sich mittlerweile bei rund 11 % eingependelt.[2] Weitere Gutachten, wie eine etwas ältere Studie des Weltwährungsfonds, weisen nach, dass den Banken nicht nur Kosten entstehen, sondern insbesondere die Kreditvergabe leidet und sich in Europa nicht soweit erholen konnte wie in den USA.[3]

Ergebnisse von zeb und der zeb.business school, die u. a. im Rahmen von durch das Bundesministerium für Bildung und Forschung (BMBF) geförderten Projekten erzielt wurden, zeigen jetzt deutlich, dass nicht nur Größe, sondern vor allem die Art und Weise der bisherigen Anstrengungen keinesfalls zu einer stabilen Sicherheitskultur in der Kreditwirtschaft führen können.

Systemfehler statt menschliches Versagen

Die Gründe für den ausbleibenden, viel beschworenen Kulturwandel liegen nicht in mangelnden Anstrengungen, sondern in einem Missverständnis der psychologischen Grundlagen einer funktionierenden Risiko- oder besser zukunftsweisenden Sicherheitskultur. Zusammen mit verschiedenen Verbundpartnern aus Wissenschaft, Industrie sowie Finanz- und Gesundheitswesen hat die zeb.business school organisatorische Anpassungs- und Innovationsprozesse untersucht, Arbeitsprozesse und Kompetenzentwicklung in hoch reliablen Organisationen (HRO) wie Flughäfen, Industrie 4.0 und Zentral-OPs von Universitätsklinika analysiert sowie eine nachhaltige Erhöhung von Sicherheitsstandards durch Telemedizin umgesetzt. Die im Folgenden dargestellten Studienergebnisse aus Medizin, Bildung und Militär zeigen, wie Fehlverhalten und Risiken in Organisationen entstehen.

Falsche Ärzte, echte Probleme

In einer Studie[4] rief ein falscher Arzt echte Krankenpfleger bzw. -schwestern an und stellte sich als Mediziner mit einem Allerweltsnamen vor. Er ordnete dann eine Überdosis eines als gefährlich eingestuften Medikaments für echte (aber zuvor von den Studienleitern eingeweihte) Patienten an. Die Sicherheitsregeln waren eigentlich klar: Es durften keine Anweisungen per Telefon entgegengenommen werden, die angeordnete Dosis betrug das Doppelte der angegebenen Maximaldosis und das Medikament war nicht zum Einsatz auf Station freigegeben. Dennoch wollten über 80 % der Pflegekräfte die vermeintliche Arztanweisung ausführen, obwohl die überwiegende Mehrzahl um die Gefahr der Anordnung wusste. In dieser Studie wurden sie daran gehindert. Aktuelle Untersuchungen gehen davon aus, dass in deutschen Krankenhäusern immer noch 5 % bis 10 % der Patientinnen und Patienten falsche Medikamente erhalten[5] – teils aus Mangel an Standards und Kompetenzen, teils aber auch aus Autoritätshörigkeit und Konformitätsdruck. Entsprechend wurde der „Aktionsplan Arzneimitteltherapiesicherheit“ ins Leben gerufen, der permanent aktualisiert wird und Ärzteschaft, Pflege und Patienten einbezieht.[6]

Blauäugig in die Diskriminierung

Risiken entstehen aber nicht nur dann, wenn Menschen über Jahre in einer hierarchischen Organisation wie einem Krankenhaus gearbeitet haben – ein rassistisch motiviertes Ereignis und das Nichthinterfragen von autoritärem Verhalten reichen völlig aus, wie ein klassischer Versuch in einer Grundschule in Iowa (USA) am Tag nach der Ermordung Martin Luther Kings am 4. April 1968 bis heute eindrucksvoll zeigt: Die Grundschullehrerin Jane Elliot wollte die Macht von Vorurteilen verdeutlichen und sagte daher ihren Schülern, dass Blauäugige klüger und besser seien als Braunäugige und sich getrennt setzen sollen. Außerdem müssen Braunäugige den Blauäugigen gehorchen. Nach einem Tag sagte sie, dass sie sich geirrt habe und Braunäugige die Überlegenen seien. Innerhalb dieser beiden Tage entstanden in der Klasse Unterdrückung, Gewalt und „Parolen“ gegen „Andersäugige“ – erst gegen Braun-, dann gegen Blauäugige.[7] Solche Studien sind immer wieder in unterschiedlicher, aus heutiger Sicht ethisch besser vertretbarer Form und in unterschiedlichen Ländern mit ähnlichen Ergebnissen wiederholt worden, auch von Jane Elliot selbst, die in einem Interview[8] von 2003 darüber berichtet.

Unmoralische Systeme

Der US-Sozialpsychologe Phil Zimbardo untersuchte in einer berühmt gewordenen Studie im Jahr 1971, wie Autorität, Diskriminierung und Unterdrückung in einem Gefängnis wirken, mit dem Ziel, die Verhältnisse in US-Gefängnissen zu verbessern.[9] Es stellte sich heraus, dass zuvor sozial eingestellte, gebildete Psychologiestudierende in einem Gefängnisszenario binnen weniger Tage bereit waren, ihre Kommilitonen z.B. durch Schlafentzug, Isolation, Beschimpfungen und Beleidigungen bis zum psychischen Zusammenbruch zu drangsalieren. Dazu reichten das Herstellen von Hierarchieunterschieden – z.B. Wärter in Uniform und Gefangene mit Nummern –, Gruppendruck sowie der Eindruck der „Gefangenen“, dass sie ihrer „Gefangenschaft“ im Keller der Standford-Universität für die geplante Dauer von zwei Wochen nicht würden entkommen können.

BankingHub-Newsletter

„(erforderlich)“ zeigt erforderliche Felder an

Aufgrund seiner Forschungstätigkeit wurde Phil Zimbardo als Gutachter bei der Untersuchung des Folterskandals im irakischen Gefängnis Abu Ghraib während des Irakkriegs 2004 bestellt. In seinem Gutachten vor Gericht verteidigte er für viele überraschend einen der Hauptangeklagten, den nachts wachhabenden Militärpolizisten des am meisten betroffenen Zellenblocks Staff Sergeant Ivan Frederick II, mit den folgenden Argumenten:

- Das Gefängnis war überfüllt, lag ständig unter Beschuss, und die Entwicklung des Geschehens war für Wärter und Organisatoren nicht absehbar.

- Wärter und Organisatoren waren nicht ausreichend ausgebildet, unterbesetzt und litten unter Schlafmangel.

- Die Vorgesetzen waren weit weg, kaum greifbar und machten breit auslegbare Vorgaben (z.B. dass Gefangene möglichst schnell verwertbare Informationen preisgeben sollten), die einen guten Zweck verfolgten (insbesondere Armeeangehörige vor Anschlägen zu bewahren).

- Es gab unterschiedliche Zuständige mit unklaren Verantwortungsbereichen (Militärpolizei, CIA, Privatfirmen, Drittländer).

Diese fatale Mischung forderte Fehlverhalten geradezu heraus und machte es dem Angeklagten unmöglich, die Folterungen zu unterbinden, an denen er selbst nicht beteiligt war.[10] Die Schilderung der Risikofaktoren macht zudem deutlich, dass im Grunde keine Organisation vor solchen Risiken gefeit ist: potenziell bedrohliche und nicht absehbare Lage, Unterbesetzung und Kompetenzmängel, unklare Vorgaben und vage, aber positive Ziele sowie sich überschneidende Zuständigkeiten und unklare Verantwortlichkeiten.[11]

Schlechter Apfel, schlechter Korb

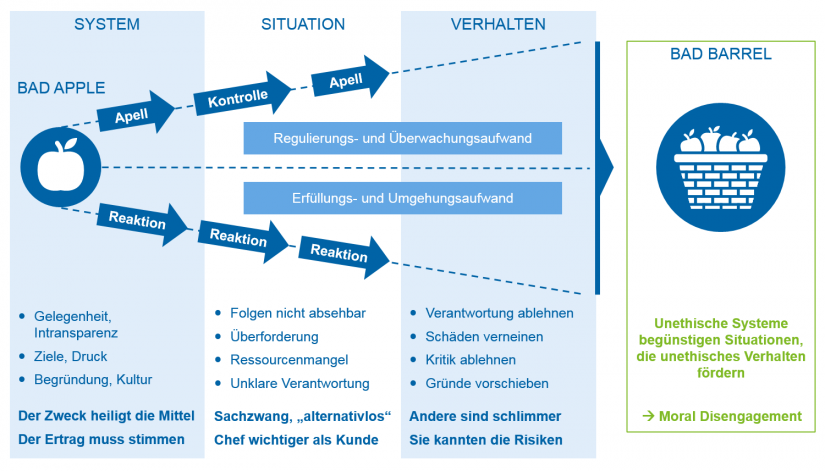

Zimbardo beschreibt das typische (Denk-)Verhalten von Menschen in solchen Organisationsstrukturen:

- Sie glauben, dass es sie persönlich nicht betrifft („Ich würde so etwas nie tun“),

- berufen sich auf Autoritäten („Ich habe nur Befehle befolgt“),

- schieben andere Personen im Umfeld vor („Ich habe mich an den anderen orientiert“),

- sehen vermeintlich geringe Schäden („Manchmal muss man Kollateralschäden akzeptieren“),

- nehmen eine passende Abwägung von Vor- und Nachteilen vor („Für mehr Sicherheit muss man auch persönliche Freiheiten aufgeben können“)

- oder geben schlicht auf („Mit ungerechten Zuständen muss man sich einfach abfinden“).

Menschen geraten in einen Zustand des „Moral Disengagement“, stellen quasi ihr Gewissen ab, um mit der belastenden Situation fertigzuwerden. Dazu ist kein Gefängnis nötig, Druck aus der Hierarchie und aus der Gruppe reicht völlig aus. Risiken und Fehlverhalten entstehen also nicht, weil in guten Systemen vereinzelte böse Menschen arbeiten, wie die Argumentation vom „Fehlverhalten Einzelner“ nach eigentlich jedem Wirtschaftsskandal glauben machen soll. Vielmehr bringen Systeme Menschen in Situationen, die ihr Verhalten prägen. In den allermeisten Fällen ist Fehlverhalten ein Systemfehler und nicht menschliches Versagen. Phil Zimbardo nennt dies den Unterschied zwischen „schlechter Apfel“ (Fehlverhalten Einzelner) und „schlechter Apfelkorb“ (System begünstigt Fehlverhalten).

Abbildung 1: Systeme schaffen Situationen, und Situationen prägen Verhalten – Fehlverhalten ist meist Folge unethischer Systeme und nicht moralisches Versagen von Einzelpersonen

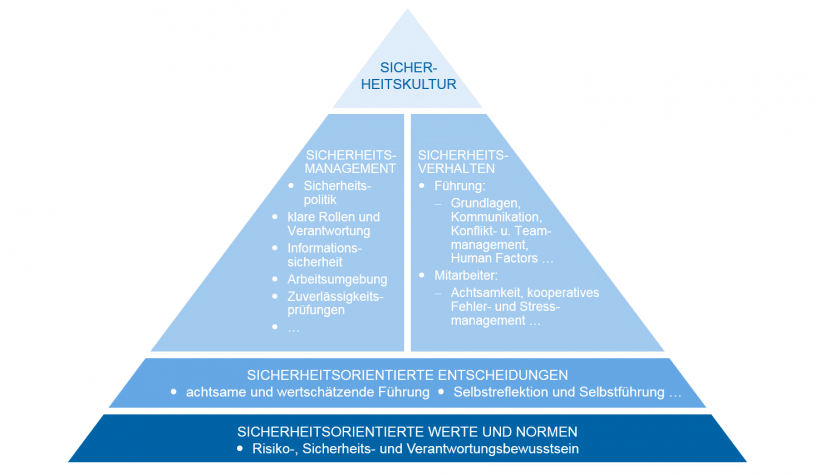

Abbildung 1: Systeme schaffen Situationen, und Situationen prägen Verhalten – Fehlverhalten ist meist Folge unethischer Systeme und nicht moralisches Versagen von EinzelpersonenEine Sicherheitskultur unterscheidet sich von einem in vielen Unternehmen bereits vorhandenen Sicherheitsmanagement vor allem dadurch, dass es ein „ethisches System“ ist: Sicherheit wird nicht nur „gemanagt“ sondern in ein System eingebettet, welches das gewünschte Verhalten gezielt fördert und unterstützt. Das bereits vorhandene Risiko- bzw. Sicherheitsmanagement ist ein wesentlicher Bestandteil einer Sicherheitskultur. Es muss aber ergänzt werden um sicherheitsförderndes Führungs- und Mitarbeiterverhalten, umfassende Mechanismen zur Lenkung von Entscheidungen und Verhalten sowie grundlegende Überzeugungen und Werte.

Abbildung 2: Sicherheitskultur-Pyramide mit Ziel einer umfassenden Sicherheitskultur und bestehendem Risiko- bzw. Sicherheitsmanagement als zentralen Bestandteil (angelehnt an 'Sicherheit im Flugverkehr' des Bundesministeriums für Bildung und Forschung)

Abbildung 2: Sicherheitskultur-Pyramide mit Ziel einer umfassenden Sicherheitskultur und bestehendem Risiko- bzw. Sicherheitsmanagement als zentralen Bestandteil (angelehnt an 'Sicherheit im Flugverkehr' des Bundesministeriums für Bildung und Forschung)