Entscheidungsträger unter Zugzwang

Der Druck auf Entscheidungsträger, ihre Finanzhäuser auf einen Weg langfristiger wirtschaftlicher Stabilität zu führen, steigt zunehmend. Diese Anforderung ergibt sich einerseits durch die Aufsicht, die verstärkt Informationen zur Finanzstabilität verlangt. Nicht selten sind diese Informationen auf ad hoc-Basis zu liefern. Gleichzeitig verlangen Shareholder seit jeher, dass ihre Renditevorstellungen auch in wirtschaftlich schwierigen Zeiten erzielt werden. Zum Nachweis nachhaltiger Finanzstabilität stellen mehrjährige Szenarioanalysen eine Basis für Banken dar, die über alle Bereiche – Risiko, Accounting, Controlling und Meldewesen – konsolidiert und häufig auch ad hoc durchzuführen sind. Ein konsistenter Datenhaushalt und darauf abgestimmte, durchgängige IT-Prozesse, wie sie aktuell aufgrund der o. g. regulatorischen Anforderungen in den Finanzhäusern erstellt wurden bzw. erweitert werden, bilden idealerweise die Grundlage hierfür. Alle relevanten Finanzdaten aus den dezentralen operativen Systemen sind hier zu einem einheitlichen Bild verbunden.

Zur Erreichung von BCBS #239-Mindestanforderungen wurden in den letzten Jahren große finanzielle Anstrengungen unternommen. Somit wäre es vorteilhaft, darauf aufbauend auch weitere Simulationsszenarien rechnen und darstellen zu können. Die Investitionen könnten sich durch weitere Funktionalitäten schneller auszahlen. Dieser Ansatz wird in dem vorliegenden Lösungsvorschlag diskutiert.

Fachliche und technische Herausforderung

Zur Erzielung einer szenariofähigen IT-Architektur sind im ersten Schritt fachliche Herausforderungen zu meistern, welche im zweiten Schritt in die IT-Architektur zu integrieren sind. Die fachlichen Herausforderungen bestehen zunächst in der Identifikation der Sensitivitäten externer Faktoren (z. B. makroökonomischer Variablen) auf die einzelnen Werttreiberbaumkomponenten von KPIs. Zu Beginn ist grundsätzlich abzuwägen, wie detailliert die Modellierungsansätze einzelner Wertkomponenten ausgestaltet werden müssen. Ein sicherlich großer Block „Personalkosten“ wird – wenn nicht explizite Anpassungsmaßnahmen geplant sind – auch in der Zukunft relativ stabil bleiben. Für Komponenten solcher Art reicht ein eher rudimentärer Simulationsansatz; wohingegen das für die Ertragslage der Bank entscheidende Zinsergebnis eine entsprechend höhere Relevanz bei der Ausgestaltung des Modellierungsansatzes zukommen sollte.

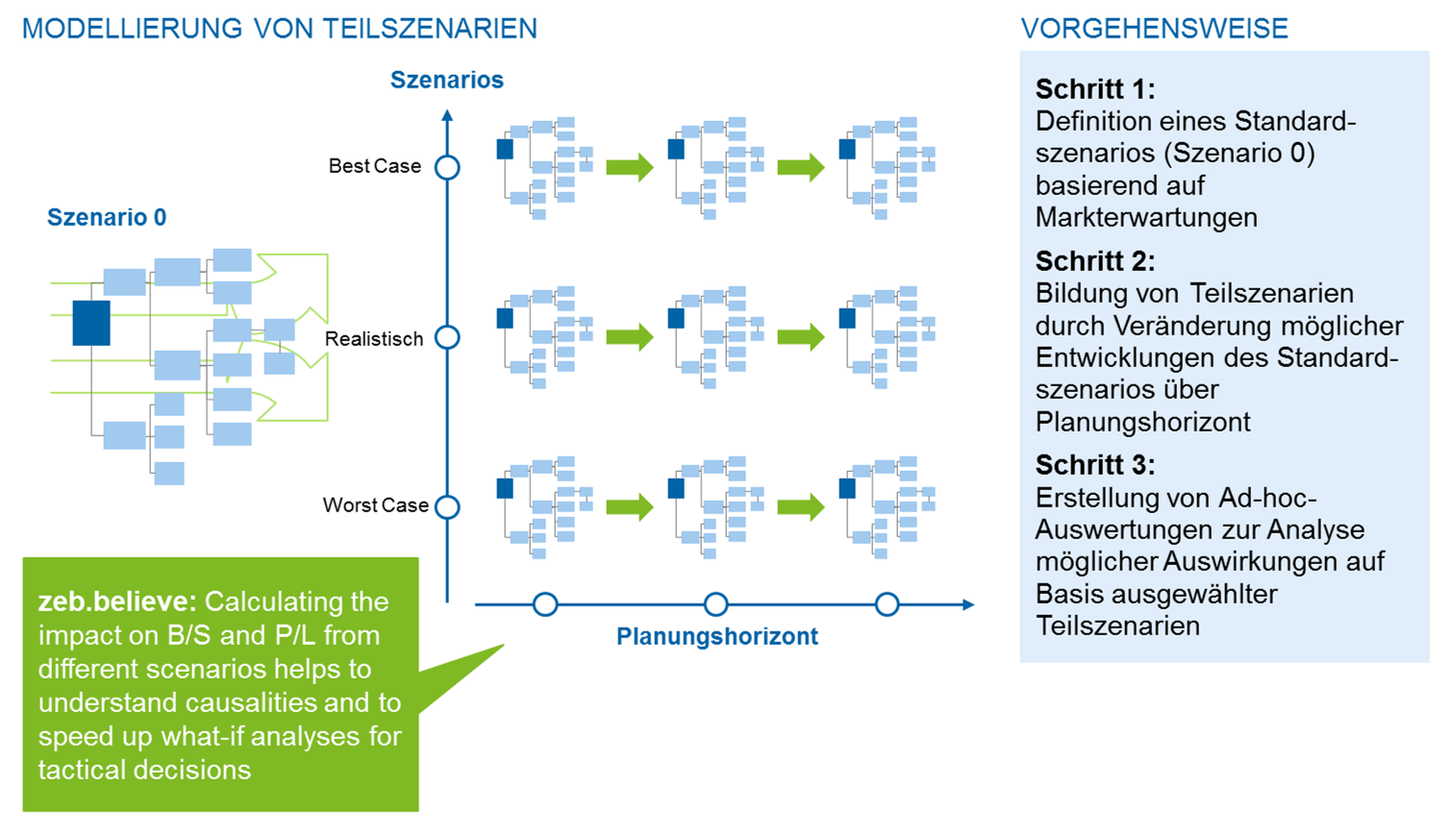

Die fachliche Zusammenstellung der Szenarien folgt in diesem Vorschlag einer vertikalen und horizontalen Szenariobildungslogik. Hierbei bedeutet die horizontale Szenariobildung eine Fortschreibung der Eingangsparameter über die Planungsperioden hinweg, während die vertikale Szenariobildung eine plausible und logische Zusammenfassung verschiedener Eingangsparameter vor dem Hintergrund allgemeiner Markterwartungen beschreibt. Die horizontale und vertikale Szenariobildung wird in Abbildung 1 skizziert.

Weitergehend wird gefordert – ausgehend von einer säulenübergreifend verdichteten Simulation – auch innerhalb der Szenarien wieder per Drill-down in die Teilergebnisse zwecks Ursachenanalysen „abtauchen“ zu können.

Erweiterung der IT-Architektur zur Szenariofähigkeit

Im nächsten Schritt gilt es, die fachlichen Anforderungen in der bestehenden IT-Architektur zu integrieren.

In den letzten Jahren aufgebaute BCBS #239-konforme IT-Infrastrukturen haben den Banken erhebliche Verbesserungen in der Risikoaggregation ermöglicht. Die fünf wesentlichen Verbesserungen sind:

- Vereinheitlichung und Überführbarkeit der Datenmodelle

- Harmonisierte Datenqualitätsprozesse

- Nachvollziehbarkeit durch Aggregations- und Data-Lineage-Konzepte

- Rechenkerne für fachliche Fragestellungen

- Einheitliches Managementreporting

Somit liegt es nahe zu prüfen, wie die IT-Infrastrukturen – um weiteren Nutzen aus den getätigten Investitionen zu ziehen und die „Zentralisierung“ nicht durch Alternativsysteme zu verwässern – zur Szenariofähigkeit ausgebaut werden können.

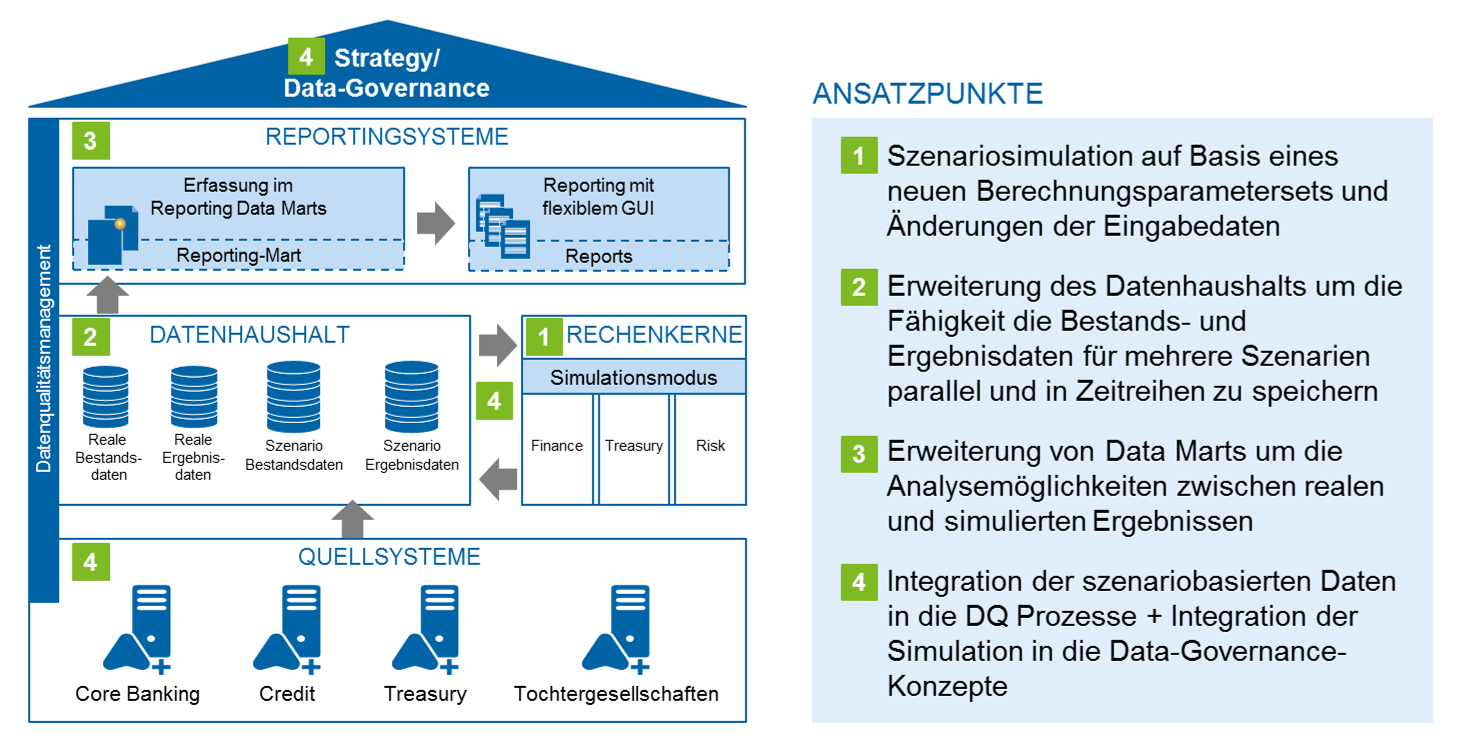

Hierbei zeigt Abbildung 2 eine schematische Gesamtsicht der IT-Infrastruktur und präsentiert die vier zentralen Ansatzpunkte.

1 Rechenkerne

Die bestehenden Rechenkerne sind darauf ausgelegt, ein Ist-Bild aufzunehmen und zu aggregieren. Dazu werden die Rohdaten – primär Stamm- und Bewegdaten – zu betriebswirtschaftlichen Kennziffern (z. B. KPIs) zusammengefasst. Besonders in der Risikobewertung werden hierzu fest definierte Sätze an Berechnungsparametern verwendet, welche auch Zukunftsprognosen beinhalten können (z. B. Marktdaten und Ratings).

Der hier besprochene Ansatz behält – so weit wie möglich – die bestehenden Rechenkerne in ihrer Form und Funktionsweise bei. Änderungen erfahren lediglich die Grundparametrisierung und die Datenversorgungsprozesse, um auch alternative Szenarien kalkulieren zu können.

Als Beispiel benötigt ein Finance-, Treasury- oder Risiko-Rechenkern als Grundlage im Wesentlichen sowohl Geschäfts- und Marktdaten als auch die Risikofaktoren. Gleiche Algorithmen und Jobs werden verwendet, um mit neu angelieferten Szenariodaten Simulationsergebnisse zu produzieren.

An dieser Stelle ist es wichtig zu beachten, dass die Parametrisierung und Datenanbindung (von Szenariodaten) effizient und nachvollziehbar durchgeführt werden und die Rechenkerne selbst ohne eigene dauerhafte Datenspeicher auskommen sollten. So können die besonderen Herausforderungen um die Prozesssynchronisation bei mehreren unabhängigen Szenarien bewältigt werden.

2 Datenhaushalt

Die zentralen Anpassungen und Herausforderungen liegen in der Data-Warehouse-Architektur. Um einen möglichst hohen Wiederverwendungsgrad der bestehenden Architektur zu erzielen, sollten die Simulationsdaten direkt in den bestehenden Datenhaushalt integriert werden. Diesem Vorschlag zufolge müssen möglichst alle Daten einem Szenario zugeordnet werden. Somit wird die Ist-Datenbasis zum Szenario „Realität“ und darüber identifiziert. Daneben existieren weitere Szenarien, die alternative Daten beinhalten. Jeder Datensatz verfügt somit über eine eigene Dimension „Szenario“. Dies gilt sowohl für die Grund- als auch die Ergebnisdaten und bedeutet keineswegs, dass der reale Datenbestand pro Szenario einmal dupliziert werden muss. Mithilfe von Delta-Szenarien werden nur die Änderungsdaten für ein neues Szenario erzeugt und gespeichert.

In fortgeschrittener Ausführung können unabhängige Sub-Szenarien, welche nur für bestimmte Bereiche (z. B. Marktdaten) gelten, mit anderen Szenarien additiv zusammengesetzt werden. Somit wird eine kombinatorische Vielfalt an Eingangsparametern zur Verfügung gestellt. Spezialabteilungen der Bank (z. B. Konzernentwicklung und Volkswirtschaft) stellen ihre Arbeitsergebnisse in einzelnen Szenarien für die Gesamtbank zur Verfügung.

Zur Sicherstellung der Wiederholbarkeit und Synchronisation bedeutet das für den Datenhaushalt neben einer Erweiterung der Schlüsselsystematik auch erhöhte Anforderungen an die darauf abgestimmten Prozesse.

3 Reportingsysteme

Die Erweiterungen des bestehenden Managementreportings stellen einen eher geringen Aufwand dar, sind jedoch unabdingbar für die Akzeptanz der Lösung. Ist-Datenbestand und Simulationsergebnisse müssen in den bestehenden Reporting-Marts klar getrennt werden, jedoch im Rahmen der effizienten Ablage ggf. auch kombiniert und verknüpft werden können. Gleiche Voraussetzungen gelten auch für die Berichterstattung. Diese sollte zur detaillierten Darstellung von Zusammensetzung der steuerungsrelevanten Größen um die Analysemöglichkeiten zwischen realen und simulierten Ergebnissen bzw. um die benötigen zusätzlichen Drill-down-Funktionalitäten erweitert werden.

4 Nicht funktionale Anforderungen und zentrale Querschnittsfunktionen

Die nicht funktionalen Anforderungen und darauf aufbauende Methodiken (z. B. Data-Quality-Management, Data-Governance etc.) sind unabdingbar für die langfristige Funktionsfähigkeit und Akzeptanz des Data-Warehouse innerhalb des Konzernes. Deshalb dürfen diese bei der Erweiterung um Simulationsergebnisse und Szenarien nicht vernachlässigt werden.

Die vorhandenen Querschnittssysteme wie z. B. zur Datensicherung, Archivierung, Benutzer- und Rechteverwaltung können im Wesentlichen ohne Modifikation weiter verwendet werden. Das führt zur Steigerung der Akzeptanz bestehender Systeme und zu einem kosteneffizienten Betrieb der IT-Architektur.

Fazit

Es zeigt sich, dass die immer wichtiger werdende Anforderung „Szenariofähigkeit“ stringent in ein bestehendes Data-Warehouse – unter Anpassung zentraler und dezentraler Komponenten – integriert werden kann. Die skizierten Erweiterungen bauen auf dem Grundgerüst der im Rahmen der BCBS #239-Umsetzung modernisierten IT-Architektur auf und „leveragen“ die getätigten Investitionen.

Die Umsetzung der Erweiterungen ist mit einigen Herausforderungen verbunden. Dabei bietet sich die Möglichkeit, evolutionär und sukzessiv mit der Umstellung der für die Bank priorisierten Bereiche zu beginnen. Eine individuell durchzuführende Ist-Analyse und der Abgleich mit zu entwickelnden Zielbildern ist unbedingt erforderlich.

Insgesamt sollte der beschriebene Ansatz sowohl kosteneffiziente und qualitativ hochwertige Prozesse als auch die Reduktion manueller Workarounds vorantreiben. In vielen Bereichen sind komplexere Abbildungen, z. B. bei der Ableitung von Berechnungsparametern aus makroökonomischen Einflussfaktoren oder bei der Darstellung alternativer Geschäftsentwicklungen in den Bestandsszenarios, denkbar und je nach Geschäftspolitik auch sinnvoll. Gleichwohl ist diese Lösungsskizze als ein erster Aufschlag zu verstehen, welcher auf die individuellen Bedürfnisse des Kreditinstituts anpasst werden muss.