Anforderungen an die Institute

Bankinterne Rating- oder Risikoklassifizierungsverfahren sind in Kredit- und Finanzdienstleistungsinstituten vor dem Hintergrund erweiterter bankenaufsichtsrechtlicher Anforderungen von sehr großer Bedeutung. Entsprechende aufsichtsrechtliche Vorgaben finden sich grundsätzlich auf nationaler Ebene in den Mindestanforderungen an das Risikomanagement (MaRisk) sowie auf europäischer Ebene im CRD-IV-Paket. Vor allem im Kontext „Future of the IRB“ und der zugehörigen EBA-Initiativen, wie den RTS zur Assessment Methodology[1] oder den Guidelines zu PD- und LGD-Schätzverfahren[2], sind direkte oder indirekte aufsichtsrechtliche Anforderungen an interne Risikomodelle und die zugehörigen Verfahren und Prozesse weiter gestiegen. Dies wird durch das Prüfungsprogramm TRIM, welches derzeit in aller Munde ist, noch einmal deutlich bestätigt und bestärkt.

Die Ratingverfahren des Instituts haben insbesondere eine aussagekräftige Beurteilung der Merkmale von Schuldner und/oder Geschäft, eine aussagefähige Risikodifferenzierung sowie exakte und einheitliche quantitative Risikoschätzungen zu liefern. Die geforderte Dokumentation und die Validierung der Systeme sind zur notwendigen Überwachung der Bonitätsbeurteilungsverfahren durch das Management des Instituts zwingend erforderlich.

BankingHub-Newsletter

„(erforderlich)“ zeigt erforderliche Felder an

Zum Nachweis der Validierung sind regelmäßig oder anlassbezogen aussagefähige Berichte über die Güte der Ergebnisse dieser Systeme zu erstellen. Somit kann das Institut gewährleisten, dass es jederzeit einen vollständigen und aktuellen Überblick über die Methoden und Verfahren hat, die zur Risikoquantifizierung verwendet werden. Dabei rückt die Fähigkeit zu unterjährigen Auswertungen und zu einem Ad-hoc-Reporting immer mehr in den Fokus. Solche Auswertungen zeitnah und unkompliziert durchzuführen, ist nur dann möglich, wenn Effizienz und Automatisierungsgrad der Verfahren erhöht werden.

Anforderungen an die Validierung von Ratingmodellen bestehen aber nicht nur aus aufsichtsrechtlicher Perspektive – die Ergebnisse der Schätzmodelle werden insbesondere auch für die Kreditvergabe und die interne Portfoliosteuerung genutzt und müssen daher zwingend zuverlässig und aktuell sein. In diesem Kontext hat die Validierung u. a. über das risikoadjustierte Pricing sowie über die Limitsystematik direkten Einfluss auf die gesamte Kreditrisikostrategie des Instituts. Hier ist es umso interessanter, auch konkrete Ad-hoc-Auswertungen durchführen zu können, um sich zeitnah über aktuelle Entwicklungen bewusst zu werden.

Vor dem umfassenden Hintergrund der aufsichtsrechtlichen sowie ökonomischen Anforderungen stellt sich in der Praxis die Frage nach einer anforderungsgerechten, aber zugleich auch effizienten Umsetzung der Validierung der Ratingverfahren.

Standardisiertes, automatisiertes Vorgehen

Die Durchführung und Auswertung von Analysen zum Zweck der Validierung von Ratingmodellen ist von jedem Institut spezifisch zu gewährleisten. Dabei ist sicherzustellen, dass alle Anforderungen der Aufsicht an den Validierungsprozess eingehalten werden. Die dazu verwendeten Vorgehensmodelle und Methoden sind häufig jedoch nicht vor dem Hintergrund der aktuellen bzw. zukünftigen Standards entstanden. Die Anforderungen an selbst entwickelte Anwendungen (IDV) sind nämlich mit dem Entwurf der MaRisk-Novelle aus 2016 nochmals deutlich verschärft worden. Dies führt dazu, dass die Verwendung von individuellen Excel- und Access-basierten Lösungen häufig deutlich eingeschränkt werden muss. Hinzu kommt, dass solche Verfahren, die eines hohen manuellen Inputs bedürfen, in der Regel fehleranfällig sind, hohe zusätzliche DQ-Aufwendungen zur Konsequenz haben und/oder im schlechtesten Fall sogar nicht steuerungsadäquate Ergebnisse der Validierung generieren.

Setzt ein Institut spezifische Ratingsysteme zur Schätzung von PDs und LGDs ein, so sind diese grundsätzlich in Bezug auf alle Kundensegmente zu validieren. Um den notwendigen Aufwand bei der regelmäßigen oder Ad-hoc-Durchführung häufig weitestgehend standardisierter Validierungsanalysen drastisch zu reduzieren sowie gleichzeitig die Fehleranfälligkeit zu minimieren bzw. die IDV-Konformität sicherzustellen, empfiehlt es sich, auf automatisierte Validierungsverfahren zurückzugreifen. Diese erlauben es, quantitative Auswertungen auf der Grundlage von implementierten Methoden und Tests mit parametrisierbaren Niveaus bzw. Grenzwerten qualitätssicher, schnell und absolut zuverlässig durchzuführen. zeb hat zu diesem Zweck eine Lösung entwickelt, die in der frei verfügbaren Software „R“ umgesetzt ist. Auf Basis der automatisch erstellten Analyseergebnisse ist die Möglichkeit gegeben, diese anschließend direkt und ohne vorherigen Aufwand zu interpretieren, zu hinterfragen und zu bewerten, um mögliche Schwachstellen der Modelle zu identifizieren.

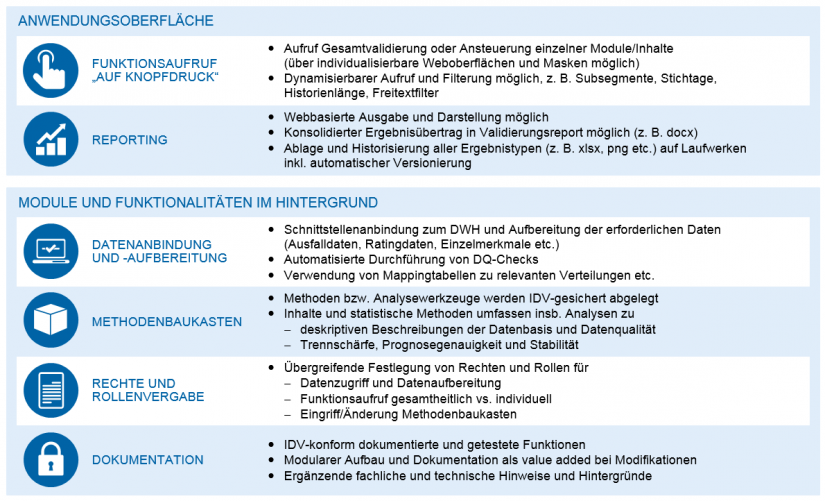

Die zeb-Lösung ist modular aufgebaut und bietet ein hohes Maß an Flexibilität in der Auswahl der durchzuführenden Methoden sowie der Berücksichtigung von Datenfeldern und der Anbindung an Datenhaushalte.

Flexibles zeb-Tool für automatisierte quantitative Validierung

Das zeb-Tool umfasst zunächst ein Modul zur Datenaufbereitung, welches sehr kundenindividuell ausgestaltet werden kann und bestmöglich direkt an das hausinterne Data-Warehouse anknüpft. In diesem werden alle benötigten vorhandenen Daten, wie Ausfalldaten, Ratings und Kundenmerkmale, welche in den Ratingverfahren verwendet werden, aggregiert und vom Tool so aufbereitetet, dass die automatisierten Analysen darauf zugreifen können.

Zusätzlich können Historien, beispielsweise Fallzahlen der Entwicklungsstichproben, und weitere Mappingdaten eingespielt werden, die z. B. für Stabilitätsanalysen, wie die Berechnung des Stabilitätsindex, benötigt werden oder die Flexibilität der Analyseverfahren gewährleisten.

Alle Methoden und Analysewerkzeuge werden in einem zentralen und gesicherten „Methodenbaukasten“ abgelegt, sodass sie bei Durchführung der Funktionsabfrage aufgerufen, gleichzeitig aber nicht (versehentlich) verändert oder bearbeitet werden können. Dies dient dem Zweck der einheitlichen Methodenverwendung und Qualitätssicherung und verhindert Fehler durch manuelle Eingriffe. Selbstverständlich können Methoden bei geplantem konzeptionellem Anpassungsbedarf durch die entsprechende Rolle angepasst werden[3]. Ebenso können natürlich Schwellwerte (Tresholds) für Tests und weitere Parameter im Tool selbst eingegeben oder angepasst werden, ohne dabei die technischen Funktionalitäten anpassen zu müssen.

Die vorhandenen Methoden können institutsspezifisch ausgewählt und „kalibriert“ werden, umfassen grundsätzlich aber die folgenden Themenblöcke:

- Trennschärfe (multivariat, univariat)

- Stabilität (Stabilitätsindex, Migrationen, langfristige Trennschärfen)

- Kalibrierung

- Auswertungen zu Ausfallgründen

- Ausreißeranalysen

Dabei sind die Methoden bzw. Funktionen so aufgebaut, dass sie durch zu übergebende Inputparameter institutsspezifisch parametrisiert werden können. Dies umfasst beispielsweise die Auswahl von (Kunden-)Segmenten, von zu analysierenden Stichtagen und Historienlängen oder die Einschränkung auf z. B. spezielle Kunden oder Forderungsklassen mithilfe von Freitextfiltern. Zudem können einzelne Analysen, Tests und Ergebnisse parametrisiert werden. Es können z. B. Konfidenzniveaus oder Beschriftungen für Grafiken, die automatisch erstellt werden, übergeben werden oder in der Ausreißeranalyse Vielfache des Interquartilsabstands oder absolute Grenzen übergeben werden, die für die Definition als Ausreißer herangezogen werden.

Während Rating- bzw. Schätz- und Validierungsverfahren im PD-Bereich häufig bereits sehr standardisiert sind, gibt es für die Schätzung und anschließende Validierung im LGD-Bereich häufig deutlich weniger homogene Modelle. Im Einsatz befinden sich unterschiedliche Methoden, wie lineare und logistische Regressionsmodelle oder Decision-Tree-Modelle (Entscheidungsbäume). Auch in der Verfahrensanwendung gibt es Unterschiede, z. B. nutzen einige Institute die Trennung von Blanko- und vollbesicherten Anteilen in Kombination mit SEQ-Schätzungen. Andere wiederum stellen auf Modelle mit Trennung nach Wiedergesundung und Abwicklung auf Kundenebene ab.

Eine Automatisierung in Analogie und Konsistenz zu PD (s. o.) ist in der Regel dennoch für alle Methoden und Anwendungsbereiche darstellbar. Die zur Validierung verwendeten Methoden sind teilweise (ggf. in ähnlicher Form) bereits im PD-Bereich in Verwendung. Die Automatisierung der eigentlichen quantitativen Validierung ist somit in der Regel problemlos möglich. Der größte Mehrwert für die Institute ist diesbezüglich aber häufig in „Phase 1“ der quantitativen Validierung (Datenaufbereitung der Verlustdaten) zu finden, welche in den Instituten meist auch den größten Teil der LGD-Validierung darstellt. Kreditnehmer-, Verlust- und Verwertungsdaten müssen manuell oft mit sehr großem Aufwand zusammengespielt und ausgewertet werden, bis mit der eigentlichen Validierung begonnen werden kann. Auch hier kann eine – zugegebenermaßen etwas aufwändigere – einmalige „Automatisierung“ langfristig zu einer deutlichen, wenn auch meist nicht vollständigen Aufwandsreduktion beitragen.

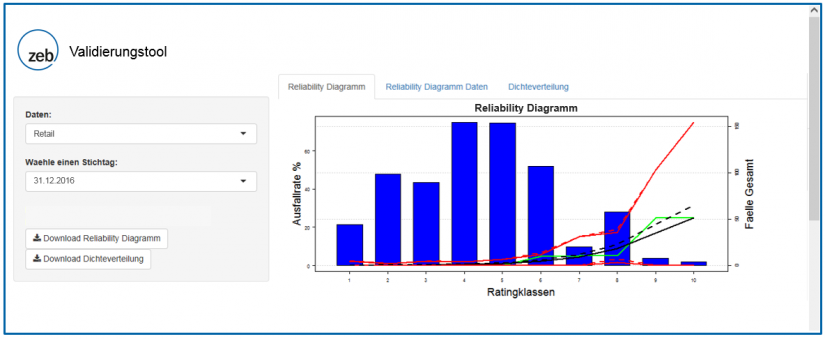

Bedienung über Weboberfläche

Oft liegt das notwendige, extrem methodenspezifische Wissen in Bezug auf das Risikocontrolling der Institute bei wenigen ausgewählten Personen, sodass die Durchführung der Validierung häufig ebenfalls auf sehr wenigen Schultern lastet. Daher ist auch die „usability“ von automatisierten Validierungstools ein großer zusätzlicher Nutzen. Zukünftig sind somit die Auswertungen über eine Weboberfläche unter Verwendung von wenigen Klicks zur Auswahl der richtigen Parametrisierung in Drop-down-Menüs durchzuführen, sodass im Prinzip jeder berechtigte Mitarbeiter vom eigenen Arbeitsplatz in kürzester Zeit die ggf. erforderlichen Ad-hoc-Analysen zur Validität der verwendeten PD- oder LGD-Verfahren ausführen kann. Die Ergebnisse der automatisch durchgeführten quantitativen Analysen können dabei beispielsweise auch direkt und ohne zusätzlichen Aufwand – z. B. in Form von institutsspezifisch parametrisierten Ampelsystematiken – in ein managementorientiertes Reporting fließen.

Fazit und Ausblick

Mithilfe von automatisierten Verfahren zur Erstellung von Validierungs- und Ad-hoc-Analyseergebnissen auf Knopfdruck kann zum einen der Aufwand der Validierung deutlich reduziert, zum anderen die Methodensicherheit bzw. -konsistenz sowie die Nutzerfreundlichkeit der Methodenanwendung erheblich verbessert werden. Dies liefert auch für diejenigen Institute einen Mehrwert, die bereits qualitativ hochwertige Validierungen vornehmen. Dieser Grad an Nutzerfreundlichkeit ist insbesondere durch die Verwendung einer Weboberfläche sichergestellt, über die jegliche, teilweise methodisch anspruchsvolle Verfahren zur Verfügung gestellt werden können.

Perspektivisch kann der als Herzstück des Validierungstools zur Verfügung stehende „Methodenbaukasten“ weiter ergänzt werden. Auf diese Weise könnte dieser z. B. für IFRS-pflichtige Institute um Verfahren zur Validierung von IFRS-9-Risikoparametern erweitert werden bzw. können bereits vorhandene Verfahren zur Validierung in einem erweiterten Kontext verwendet werden. Auch für Institute, die externe Ratingverfahren verwenden, kann das Validierungstool einen Mehrwert liefern, indem es Ad-hoc-Analysemöglichkeiten bietet. Darüber hinaus können Methoden zur Durchführung von Repräsentativitätsnachweisen ergänzt werden, die somit standardisiert, schnell und qualitätsgesichert regelmäßig umgesetzt werden können, um insbesondere die Anforderungen aus den angesprochenen neuen Regularien zu erfüllen.