Datenintegration: Aktueller Hintergrund

Trifft ein Unternehmen strategische Entscheidungen, ist eine Analyse des eigenen Makroumfelds ein fester Bestandteil der Entscheidungsfindung in Bezug auf die künftige Unternehmensentwicklung. Als Entscheidungsgrundlage greift man oft zu Tools und Modellen, die u. a. die Marktentwicklungen sowie deren Auswirkungen auf das Unternehmen beschreiben und eine fundierte Entscheidungsbasis für das strategische Management bieten.

In diesem Artikel legen wir den Fokus auf Kreditinstitute und insbesondere auf deren Business-Intelligence(BI)-Strategie. In Anbetracht der sich immer weiter verschärfenden Rahmenbedingungen im Bankenumfeld gewinnen vor allem regulatorische und technologische Aspekte sowie Wettbewerbsfaktoren bei künftigen BI-Strategiefindungen für das Management primär an Bedeutung.

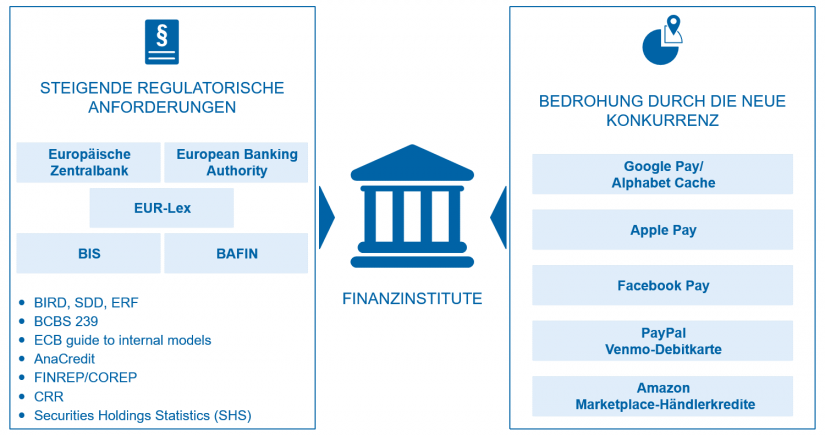

In erster Linie standen die Banken in den vergangenen Jahren vor gewaltigen regulatorischen Herausforderungen. Zu den komplexeren und kostenintensiven Rahmenwerken, die umzusetzen waren – und heute noch sind –, zählen u. a. BCBS 239, AnaCredit und IFRS 9.

Im Rahmen der Umsetzung ist die Datenverfügbarkeit ein zentraler Erfolgsfaktor, was die Erzielung regulatorischer Effizienz zu einem der wichtigsten Managementthemen für nahezu jede betroffene Bank gemacht hat. Die künftigen Initiativen der Regulatoren machen es den Banken auch in Zukunft nicht leicht: Mit u. a. BIRD, SDD, ERF oder SHS werden die Anforderungen zu granularen und einheitlichen Daten weiterhin intensiviert.

Ferner zwingen die rasante technologische Entwicklung und der Umbruch zur Digitalisierung die Kreditinstitute bei ihrem strategischen Management, insbesondere auf die technologischen Aspekte und die Wettbewerbsfaktoren zu achten. Die führenden Player im, aber auch außerhalb des Finanzsektors setzen daher stark auf den Informationsgewinn mithilfe der verfügbaren Daten für sowohl ökonomische als auch risikoorientierte Steuerung des eigenen Unternehmens.[1]

Dieser Trend in der Bankenbranche erklärt sich leicht: Neue Wettbewerber wie Apple Pay und Co. stellen eine latente Bedrohung für die Banken dar, da sie die Daten bereits heute effektiver bewerten, nutzen und daraus einen Wettbewerbsvorteil generieren können. Den Tech-Riesen ist länger bekannt, dass Banken über einen enormen Datenschatz verfügen, und versuchen daher mit innovativen Maßnahmen Zugang zu diesen Daten zu erhalten.

Abbildung 1: Aktuelle Herausforderungen durch stetig steigende regulatorische Anforderungen und neue Player im Bankenumfeld

Abbildung 1: Aktuelle Herausforderungen durch stetig steigende regulatorische Anforderungen und neue Player im BankenumfeldStatus quo Datenintegration: Daten bei vielen Kreditinstituten uneinheitlich und nicht integriert

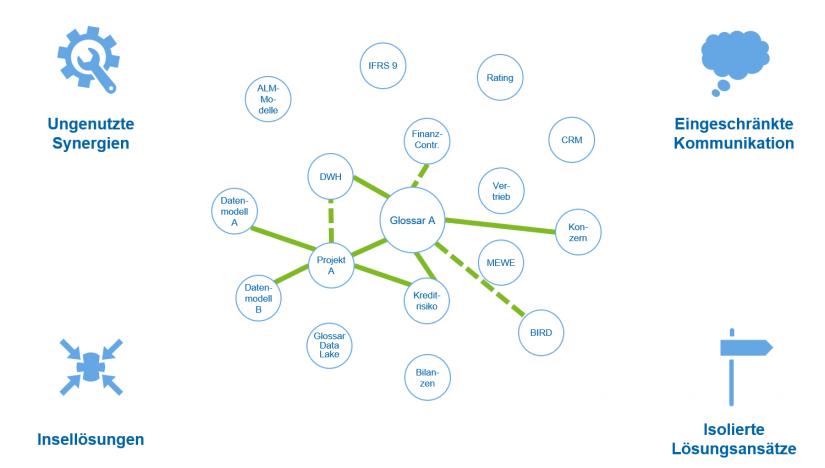

Die oben beschriebenen Herausforderungen lösen aktuell u. a. eine hohe Signifikanz von bankweiter Dateneinheitlichkeit und -transparenz aus. Dennoch besitzen die meisten Kreditinstitute noch immer eine Vielzahl an Datensilos, die als Folge verschiedener Verarbeitungsstränge entstanden sind. Sie beziehen sich generell auf dieselbe Datenbasis, allerdings sind die Daten aufgrund von unterschiedlichen Aufbereitungen, Filterungen oder Definitionen der Dimensionen auf Reportebene nur mit viel Aufwand vergleich- bzw. überleitbar.[2] Solche Datensilos verursachen bei den Banken unnötig hohe Kosten für IT, interne und zusätzliche externe Ressourcen.

In den datenverarbeitenden Fachbereichen und Projekten werden oft durch isolierte Lösungsansätze parallel – teils neue – heterogene Datenlandschaften ohne eine zentrale Datenarchitektur aufgebaut. Dabei sind die Daten in den Fachbereichen fachlich oft eigenspezifisch definiert, wodurch die bankübergreifende Kommunikation stark limitiert ist und eine technische Schnittstelle nur mit einem großen fachlichen und auch technischen Support aufgebaut werden kann.

Isolierte Datenlandschaften bergen eine große Gefahr und beeinträchtigen die Reaktionszeit des Managements der Banken bei vielen wesentlichen Strategiethemen wie Digitalisierung oder der Ad-hoc-Fähigkeit bei Marktveränderungen stark. Beispielsweise lassen der Wettbewerbsdruck aufgrund des Negativtrends der Niedrigzinsphase und die sinkenden Erträge im Privatkundengeschäft wenig Spielraum für eine Margenausweitung. Um dennoch ein nachhaltiges Wachstum der Banken zu ermöglichen, sind kundenorientierte Vertriebsentwicklung und Kundenbindung Schlüssel zum Erfolg. Eine moderne und gut aufgestellte Business Intelligence, die die Datenintegrität und -verfügbarkeit unternehmensweit einheitlich gewährleistet, zählt zu den zentralen Erfolgsfaktoren, auf die zukünftig ein Schwerpunkt gelegt werden sollte.

BankingHub-Newsletter

„(erforderlich)“ zeigt erforderliche Felder an

Vision einer vollständig integrierten Datenwelt: Unternehmensglossar 2.0

Der Basler Ausschuss für Bankenaufsicht hat mit den Grundsätzen in BCBS 239 bereits die Richtung weg von historisch gewachsenen, ineffizienten Silostrukturen hin zu der Schaffung einer gemeinsamen Sprache der Daten mithilfe eines Glossars (Dictionary) aller risikorelevanten Daten gegeben.

Doch die aktuelle Marktsituation und der Digitalisierungstrend erfordern es, aus den Schlüssen der Grundsätze auch einen ökonomischen Aspekt zu folgern, in dem die strategische Ausrichtung auf ein unternehmensweit einheitliches Datenverständnis nicht nur für die Risikosteuerung gilt, sondern viel mehr auf die Gesamtheit aller Daten im Unternehmen gelegt wird.

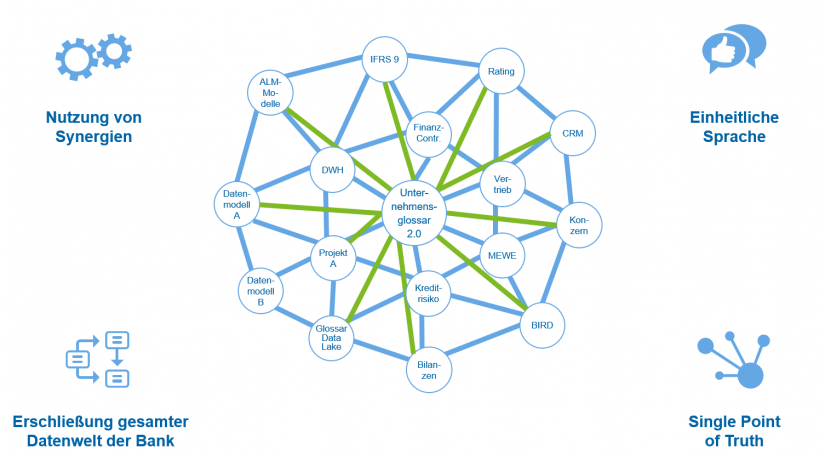

Das angestrebte Ziel hierbei ist, sämtliche Informationen der Daten (bereichs- und themenübergreifend) einer Bank integriert und einheitlich in einem Unternehmensglossar 2.0 vorzuhalten. Die wesentlichen Unterschiede zu den bisherigen Datenmodellen bzw. Datenglossaren sind die institutsspezifische Singularität und die Verkörperung des „Single Point of Truth“ im Kontext der fachlichen Definitionen und Zusammenhänge der Daten im gesamten Unternehmen. Die damit bewusst herbeigeführte unternehmensweit einheitliche Sicht auf die Daten ermöglicht eine Vernetzung der einzelnen Datenhaushalte eines Unternehmens untereinander.

Die zeitgleiche Entwicklung von themen- und systemspezifischen Datenmodellen wie z. B. einem CRM-Datenmodell ist weiterhin möglich und sogar erwünscht. Die einzige Bedingung hierbei ist, dass die Entwicklung der Modelle auf Basis des Unternehmensglossars 2.0 erfolgen muss. Nur so kann eine bankweite Gültigkeit der fachlichen Beschreibungen und Strukturen der Daten sichergestellt und der Entstehung von Datensilos entgegengewirkt werden. Für bereits historisch existente Datenstrukturen und -modelle besteht die Herausforderung, die Übertragbarkeit auf das Unternehmensglossar durch Harmonisierung nachträglich herzustellen.

Ist der Entschluss gefallen, die Datenarchitektur in Richtung Unternehmensglossar 2.0 zu entwickeln, hat man ein zukunftssicheres Fundament für eine ganzheitliche und reaktionsschnelle Kommunikationsfähigkeit innerhalb des Unternehmens sowie die Ad-Hoc Fähigkeit im Makroumfeld geschaffen.

Abbildung 3: Zukunftsbild der Datenwelt/-modelle bei Banken – Vernetzung aller Datenlandschaften bereichs- und projektübergreifend

Abbildung 3: Zukunftsbild der Datenwelt/-modelle bei Banken – Vernetzung aller Datenlandschaften bereichs- und projektübergreifendEin wesentlicher Vorteil der architektonisch geschaffenen Transparenz ist die optimale Nutzung von Synergien. Das Vorgehen birgt dadurch ein erhebliches Einsparpotenzial bei allen künftigen Herausforderungen wie z. B. bei den Projekten, die sich der Definitionen und Strukturen (Relationen und Abhängigkeiten) der Daten im Unternehmensglossar 2.0 bedienen können und keine ständigen Ressourcen aus den Fachbereichen binden müssen. Besonders neue Datenlandschaften z. B. für Digitalisierungs- und Kundenbindungsprojekte genießen alle Vorzüge des geschaffenen integrierten Datenglossars.

Datenintegration – Datenglossar: Zentrales Medium im BI-Umfeld

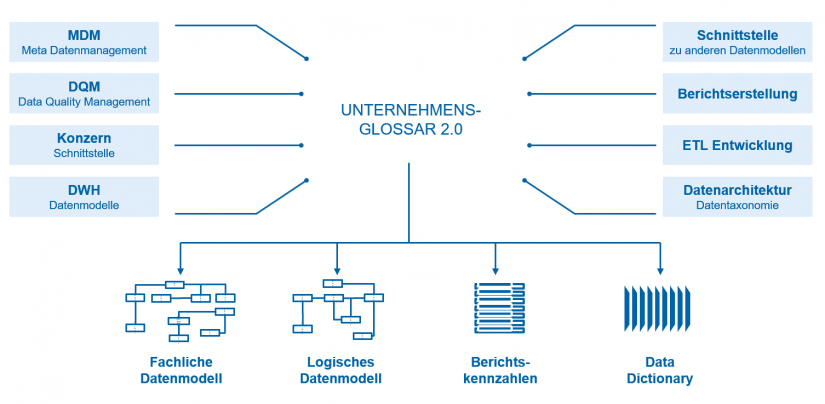

In einem modernen BI-Umfeld bildet das unternehmensweite Datenglossar das Fundament und liefert wichtige Informationen, auf deren Basis u. a. das Datenmanagement und die Konzernkommunikation aufgebaut und betrieben werden.

Die Vollständigkeit und Integrität des Unternehmensglossars 2.0 zeichnet sich durch die vier Komponenten wie in Abbildung 4 dargestellt aus. Das fachliche Datenmodell (FDM) stellt fachliche Informationsstrukturen und Geschäftsobjekte in Form eines Entity-Relationship-Modells prozess- und systemunabhängig dar. Das FDM gewährleistet zudem die Einhaltung relevanter Anforderungen und Grundsätze, u. a. die integrierte bankweite Datentaxonomie durch die eindeutigen Kennzeichnungen und Definitionen der Datenelemente, um ein einheitliches Verständnis der Bank zu sichern. Die logische Übersetzung der fachlichen Sicht auf die Daten erfolgt im logischen Datenmodell (LDM) und dient gleichzeitig als Vorlage für die physische Umsetzung z. B. des DWH. Eine weitere Darstellungsform neben den granularen Basisdaten ist die Bereitstellung institutsspezifischer Berichtskennzahlen. Das Data Dictionary besteht aus allen relevanten fachlichen Attributen – abgeleitet vom FDM –, die insbesondere für das DQM und Data Ownership benötigt werden.

Mehrwert eines Unternehmensglossars 2.0

Mit dem Unternehmensglossar 2.0 agieren die Banken zukunftsorientiert und bringen die Datenintegration und Harmonisierung der Daten im eigenen Hause voran. Zusammengefasst wird folgender Mehrwert generiert:

- Einheitliches Verständnis aller Daten zwischen den relevanten funktionalen Bereichen der Bank und Abbau von Siloarchitekturen.

- Zentrale Nachweisstelle für die Verwendung fachlicher Begriffe in der Bank; bei Unklarheiten gilt die Definition des Unternehmensglossars fachbereichsübergreifend.

- Grundlage für neue Technologien zur Datensammlung und -analyse wie z. B. Big Data.

- Höhere Innovationskraft und eine schnellere Time-2-Market-Reaktion.

- Solide und konsistente Datenbasis für aktuelle und zukünftige wachsende aufsichtsrechtliche Anforderungen.

- Grundlage einer modernen BI-Organisation.

- Abgesehen von den initialen Rollout-Aufwänden ist der Aufwand durch die interdisziplinare Zusammenarbeit mit vergleichsweise geringen Run-(Mehr-)Kosten verbunden.

Datenintegration: Fazit und Ausblick

Für eine effiziente und zukunftsfähige interdisziplinäre Kommunikation innerhalb der Bank und die Reaktivität auf die aktuellen und kommenden Herausforderungen ist eine einheitliche, integrierte Sprache der Daten in einem semantischen Datenmodell essenziell. Dabei hilft ein bankweites Unternehmensglossar den Kreditinstituten, eigene Daten zu verstehen und als Basis für die nachhaltige eigene Weiterentwicklung zu nutzen.

Der Fokus liegt in einem ersten Schritt auf einer institutsspezifischen Infrastruktur bzw. Datenarchitektur. Sobald die Aktivitäten zu spürbaren Ergebnissen führen, kann der Fokus auf Konzernstrukturen ausgeweitet und ein Konzernglossar implementiert werden, um insbesondere die Ad-hoc-Fähigkeit im Konzern zu stärken.

Vor dem aktuellen Hintergrund der zentralen strategischen Themen sollten die Kreditinstitute daher den Status quo der eigenen Datenhaltung analysieren und die proaktiven und nötigen Maßnahmen zur Datenintegration in sinnvollem und angemessenem Umfang angehen.